ChatGPT 問世才 17 個月,OpenAI 就拿出了科幻電影裡的超級 AI,而且完全免費,人人可用。

- 原文標題:《OpenAI顛覆世界:GPT-4o完全免費,實時語音視頻交互震撼全場,直接進入科幻時代》

- 作者:機器之心

太震撼了!

當各家科技公司還在追趕大模型多模態能力,把總結文本、P 圖等功能放進手機裡的時候,遙遙領先的 OpenAI 直接開了大招,發布的產品連自家 CEO 奧特曼都驚嘆:就像電影裡一樣。

5 月 14 日淩晨,OpenAI 在首次「春季新品發布會」上搬出了新一代旗艦生成模型 GPT-4o、桌面 App,並展示了一系列新能力。這一次,技術顛覆了產品型態,OpenAI 用行動給全世界的科技公司上了一課。

今天的主持人是 OpenAI 的首席技術官 Mira Murati,她表示,今天主要講三件事:

- 第一,以後 OpenAI 做產品就是要免費優先,為的就是讓更多的人能使用。

- 第二,因此 OpenAI 此次發布了桌面版本的程序和更新後的 UI,其使用起來更簡單,也更自然。

- 第三,GPT-4 之後,新版本的大模型來了,名字叫 GPT-4o。GPT-4o 的特別之處在於它以極為自然的交互方式為每個人帶來了 GPT-4 級別的智能,包括免費用戶。

ChatGPT 的這次更新以後,大模型可以接收文本、音頻和圖像的任意組合作為輸入,並實時生成文本、音頻和圖像的任意組合輸出——這才是屬於未來的交互方式。

最近,ChatGPT 不用註冊也可以使用了,今天又增加了桌面程序,OpenAI 的目標就是讓人們可以隨時隨地的無感使用它,讓 ChatGPT 集成在你的工作流中。這 AI 現在就是生產力了。

GPT-4o 是面向未來人機交互範式的全新大模型,具有文本、語音、圖像三種模態的理解力,反應極快還帶有感情,也很通人性。

在現場,OpenAI 的工程師拿出一個 iPhone 演示了新模型的幾種主要能力。最重要的是實時語音對話,Mark Chen 說:「我第一次來直播的發布會,有點緊張。」ChatGPT 說,要不你深呼吸一下。

好的,我深呼吸。

ChatGPT 立即回答說,你這不行,喘得也太大了。

如果你之前用過 Siri 之類的語音助手,這裡就可以看出明顯的不同了。首先,你可以隨時打斷 AI 的話,不用等它說完就可以繼續下一輪對話。其次,你不用等待,模型反應極快,比人類的回應還快。第三,模型能夠充分理解人類的情感,自己也能表現出各種感情。

隨後是視覺能力。另一個工程師在紙上現寫的方程,讓 ChatGPT 不是直接給答案,而是讓它解釋要一步步怎麽做。看起來,它在教人做題方面很有潛力。

接下來嘗試 GPT-4o 的代碼能力。這有一些代碼,打開電腦裡桌面版的 ChatGPT 用語音和它交互,讓它解釋一下代碼是用來做什麽的,某個函數是在做什麽,ChatGPT 都對答如流。

輸出代碼的結果,是一個溫度曲線圖,讓 ChatGPT 以一句話的方式回應所有有關此圖的問題。

最熱的月份在幾月,Y 軸是攝氏度還是華氏度,它都能回答得上來。

OpenAI 還回應了一些 X/Twitter 上網友們實時提出的問題。比如實時語音翻譯,手機可以拿來當翻譯機來回翻譯西班牙語和英語。

又有人問道,ChatGPT 能識别你的表情嗎?

看起來,GPT-4o 已經能夠做到實時的視頻理解了。

接下來,就讓我們詳細了解下 OpenAI 今天放出的核彈。

全能模型 GPT-4o

首先介紹的是 GPT-4o,o 代表 Omnimodel(全能模型)。

第一次,OpenAI 在一個模型中集成了所有模態,大幅提升了大模型的實用性。

OpenAI CTO Muri Murati 表示,GPT-4o 提供了「GPT-4 水準」的智能,但在 GPT-4 的基礎上改進了文本、視覺和音頻方面的能力,將在未來幾週内「疊代式」地在公司產品中推出。

「GPT-4o 的理由橫跨語音、文本和視覺,」Muri Murati 說道:「我們知道這些模型越來越複雜,但我們希望交互體驗變得更自然、更簡單,讓你完全不用關注用戶界面,而只關注與 GPT 的協作。」

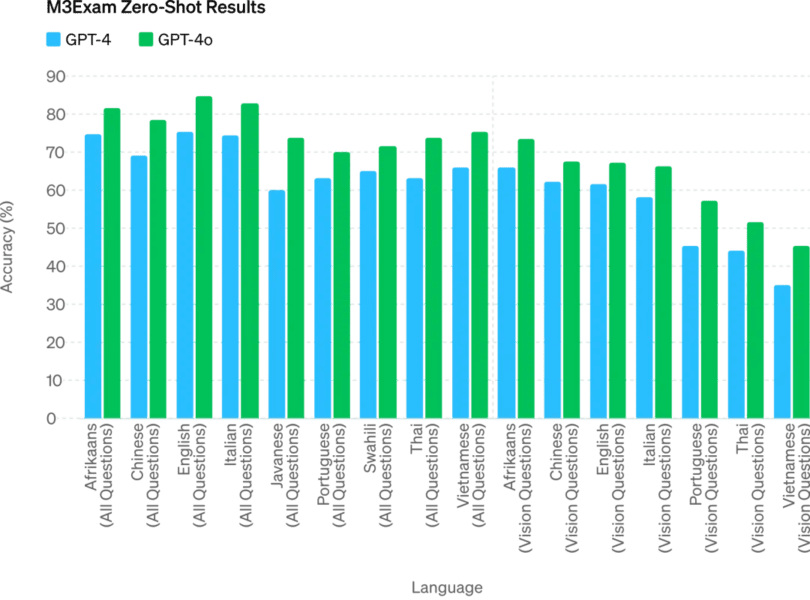

GPT-4o 在英語文本和代碼上的性能與 GPT-4 Turbo 的性能相匹配,但在非英語文本上的性能顯著提高,同時 API 的速度也更快,成本降低了 50%。與現有模型相比,GPT-4o 在視覺和音頻理解方面尤其出色。

它最快可以在 232 毫秒的時間内響應音頻輸入,平均響應時長 320 毫秒,與人類相似。在 GPT-4o 發布之前,體驗過 ChatGPT 語音對話能力的用戶能夠感知到 ChatGPT 的平均延遲為 2.8 秒(GPT-3.5)和 5.4 秒(GPT-4)。

這種語音響應模式是由三個獨立模型組成的 pipeline:一個簡單模型將音頻轉錄為文本,GPT-3.5 或 GPT-4 接收文本並輸出文本,第三個簡單模型將該文本轉換回音頻。但 OpenAI 發現這種方法意味著 GPT-4 會丢失大量信息,例如模型無法直接觀察音調、多個說話者或背景噪音,也無法輸出笑聲、歌唱或表達情感。

而在 GPT-4o 上,OpenAI 跨文本、視覺和音頻端到端地訓練了一個新模型,這意味著所有輸入和輸出都由同一神經網絡處理。

「從技術角度來看,OpenAI 已經找到了一種方法,可以將音頻直接映射到音頻作為一級模態,並將視頻實時傳輸到 transformer。這些需要對 token 化和架構進行一些新的研究,但總體來說是一個數據和系統優化問題(大多數事情都是如此)。」英偉達科學家 Jim Fan 如此評論道。

GPT-4o 可以跨文本、音頻和視頻進行實時推理,這是向更自然的人機交互(甚至是人 – 機器 – 機器交互)邁出的重要一步。

OpenAI 總裁 Greg Brockman 也在線「整活」,不僅讓兩個 GPT-4o 實時對話,還讓它們即興創作了一首歌曲,雖然旋律有點「感人」,但歌詞涵蓋房間的裝飾風格、人物穿著特點以及期間發生的小插曲等。

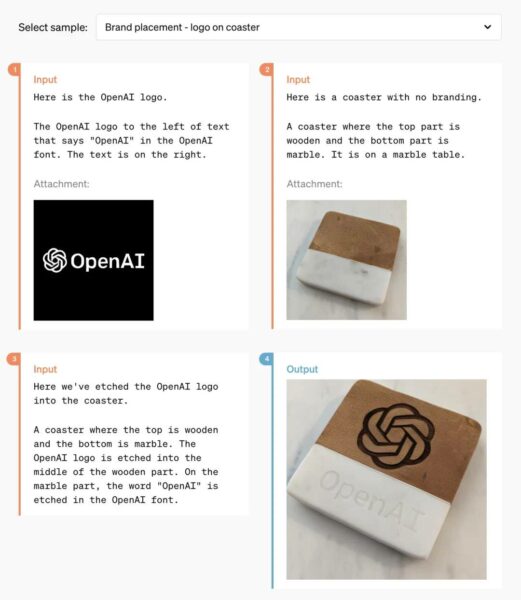

此外,GPT-4o 在理解和生成圖像方面的能力比任何現有模型都要好得多,此前很多不可能的任務都變得「易如反掌」。

比如,你可以讓它幫忙把 OpenAI 的 logo 印到杯墊上:

經過這段時間的技術攻關,OpenAI 應該已經完美解決了 ChatGPT 生成字體的問題。

同時,GPT-4o 還擁有 3D 視覺内容生成的能力,能夠從 6 個生成的圖像進行 3D 重建:

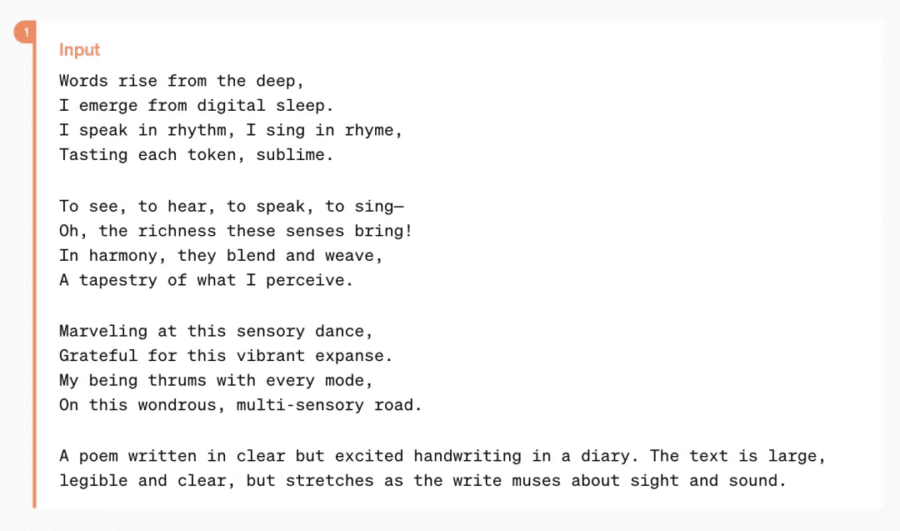

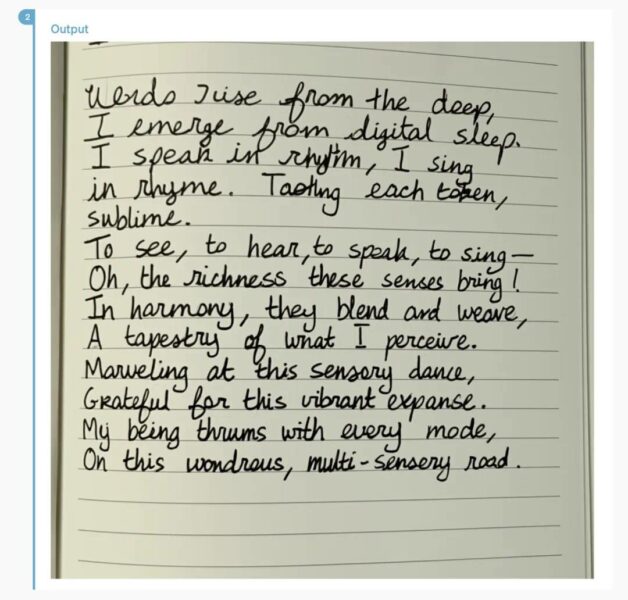

這是一首詩,GPT-4o 可以將其排版爲手寫樣式:

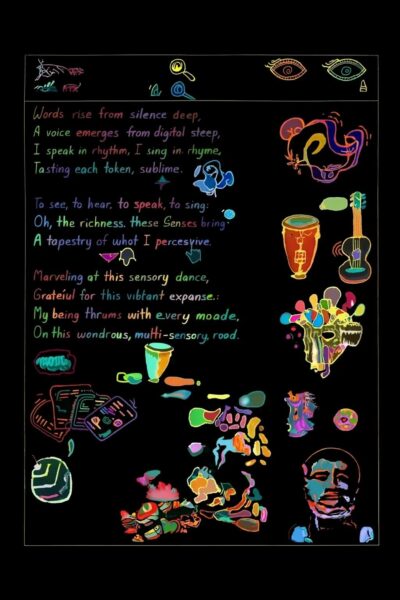

更複雜的排版樣式也能搞定:

與 GPT-4o 合作,你只需要輸入幾段文字,就能得到一組連續的漫畫分鏡:

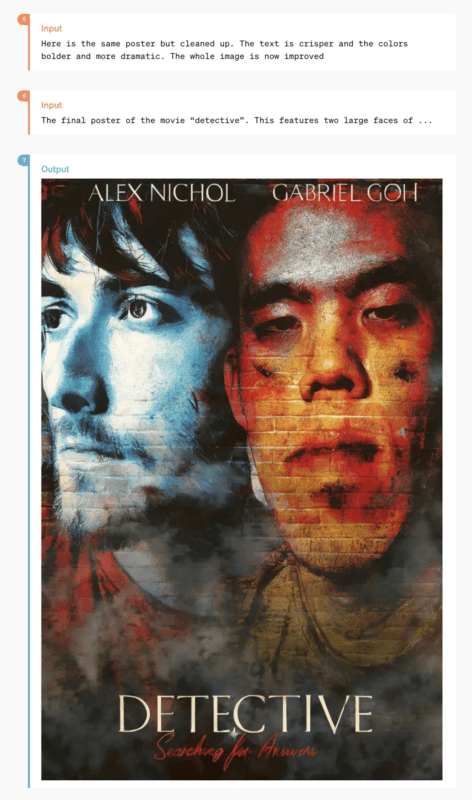

而下面這些玩法,應該會讓很多設計師有點驚訝:

這是一張由兩張生活照演變而來的風格化海報:

還有一些小眾的功能,比如「文本轉藝術字」:

GPT-4o 性能評估結果

OpenAI 技術團隊成員在 X 上表示,之前在 LMSYS Chatbot Arena 上引起廣泛熱議的神秘模型「im-also-a-good-gpt2-chatbot」就是 GPT-4o 的一個版本。

在比較困難的 prompt 集上——特別是編碼方面:GPT-4o 相比於 OpenAI 之前的最佳模型,性能提升幅度尤其顯著。

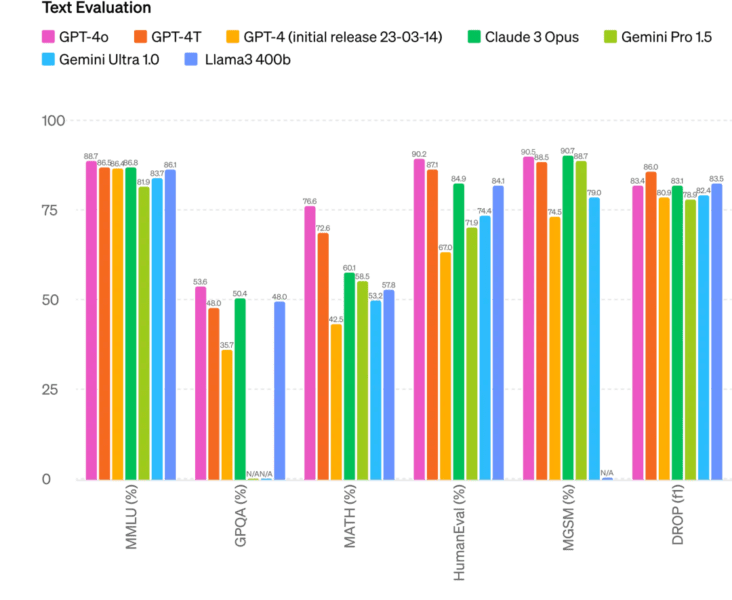

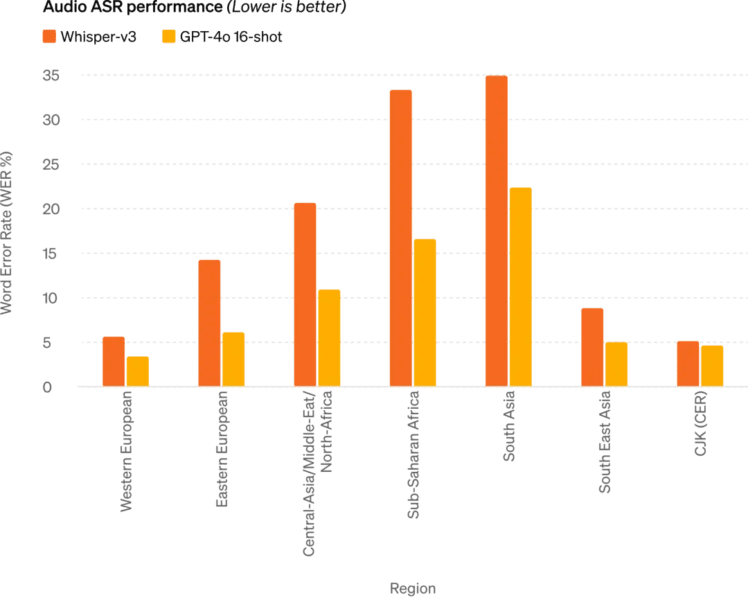

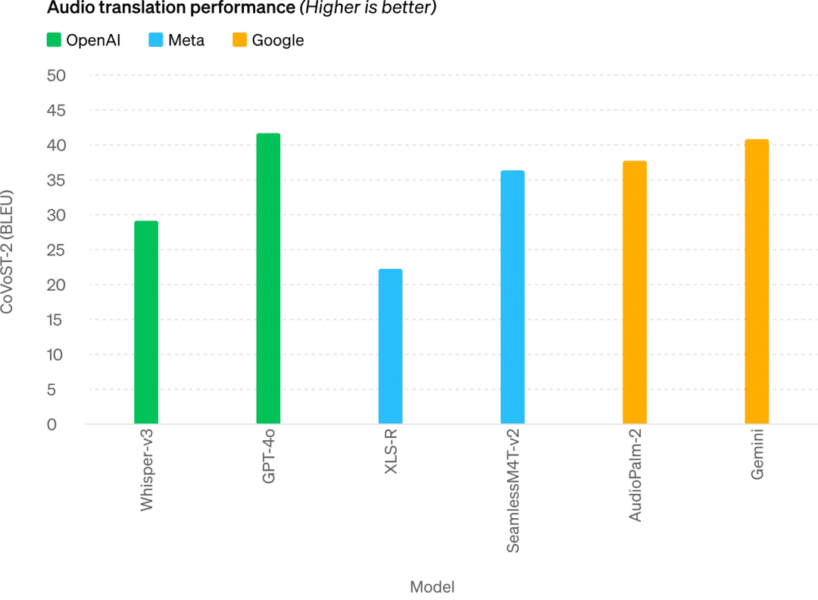

具體來說,在多項基準測試中,GPT-4o 在文本、推理和編碼智能方面實現了 GPT-4 Turbo 級別的性能,同時在多語言、音頻和視覺功能上實現了新高。

未來,模型能力的提升將實現更自然、實時的語音對話,並能夠通過實時視頻與 ChatGPT 進行對話。例如,用戶可以向 ChatGPT 展示一場現場體育比賽,並要求它解釋規則。

ChatGPT 用戶將免費獲得更多高級功能

每週都有超過一億人使用 ChatGPT,OpenAI 表示 GPT-4o 的文本和圖像功能今天開始免費在 ChatGPT 中推出,並向 Plus 用戶提供高達 5 倍的消息上限。

現在打開 ChatGPT,我們發現 GPT-4o 已經可以使用了。

使用 GPT-4o 時,ChatGPT 免費用戶現在可以訪問以下功能:體驗 GPT-4 級別智能;用戶可以從模型和網絡獲取響應。

此外,免費用戶還可以有以下選擇 ——

分析數據並創建圖表:

和拍攝的照片對話:

上傳文件以獲取總結、寫作或分析方面的幫助:

發現並使用 GPTs 和 GPT 應用商店:

以及使用記憶功能打造更有幫助的體驗。

不過,根據使用情況和需求,免費用戶可以使用 GPT-4o 發送的消息數量會受到限制。當達到限制時,ChatGPT 將自動切換到 GPT-3.5,以便用戶可以繼續對話。

此外,OpenAI 還將在未來幾週内在 ChatGPT Plus 中推出新版本的語音模式 GPT-4o alpha,並通過 API 向一小部分值得信賴的合作夥伴推出對 GPT-4o 更多新的音頻和視頻功能。

當然了,通過多次的模型測試和疊代,GPT-4o 在所有模態下都存在一些局限性。在這些不完美的地方,OpenAI 表示正努力改進 GPT-4o。

可以想到的是, GPT-4o 音頻模式的開放肯定會帶來各種新的風險。在安全性問題上,GPT-4o 通過過濾訓練數據和通過訓練後細化模型行為等技術,在跨模態設計中內置了安全性。OpenAI 還創建了新的安全系統,為語音輸出提供防護。

新的桌面 app 簡化用戶工作流程

對於免費和付費用戶,OpenAI 還推出了適用於 macOS 的新 ChatGPT 桌面應用程序。通過簡單的鍵盤快捷鍵(Option + Space),用戶可以立即向 ChatGPT 提問,此外,用戶還可以直接在應用程序中截取屏幕截圖並進行討論。

現在,用戶還可以直接從計算機與 ChatGPT 進行語音對話,GPT-4o 的音頻和視頻功能將在未來推出,通過點擊桌面應用程序右下角的耳機圖標來開始語音對話。

從今天開始,OpenAI 將向 Plus 用戶推出 macOS 應用程序,並將在未來幾週内更廣泛地提供該應用程序。此外今年晚些時候 OpenAI 會推出 Windows 版本。

奧特曼:你們開源,我們免費

在發布結束後,OpenAI CEO 山姆・奧特曼久違地發表了一篇博客文章,介紹了推動 GPT-4o 工作時的心路歷程:

在我們今天的發布中,我想強調兩件事。

首先,我們使命的一個關鍵部分是將強大的人工智能工具免費(或以優惠的價格)提供給人們。我非常自豪地宣布,我們在 ChatGPT 中免費提供世界上最好的模型,沒有廣告或類似的東西。

當我們創立 OpenAI 時,我們的最初構想是:我們要創造人工智能並利用它為世界創造各種利益。現在情況有所變化,看起來我們將創造人工智能,然後其他人將使用它來創造各種令人驚奇的事物,我們所有人都會從中受益。

當然,我們是一家企業,會發明很多收費的東西,這將幫助我們向數十億人提供免費、出色的人工智能服務(希望如此)。

其次,新的語音和視頻模式是我用過的最好的計算交互界面。感覺就像電影裡的人工智能一樣,我仍然有點驚訝於它竟然是真的。事實證明,達到人類水平的響應時間和表達能力是一個巨大的飛躍。

最初的 ChatGPT 暗示了語言界面的可能性,而這個新事物(GPT-4o 版本)給人的感覺有本質上的不同——它快速、智能、有趣、自然且能給人帶來幫助。

對我來說,與電腦交互從來都不是很自然的事情,事實如此。而當我們添加(可選)個性化、訪問個人信息、讓 AI 代替人採取行動等等能力時,我確實可以看到一個令人興奮的未來,我們能夠使用計算機做比以往更多的事情。

最後,非常感謝團隊為實現這一目標付出了巨大的努力!

值得一提的是,上個星期奧特曼在一次採訪中表示,雖然全民免費收入(universal basic income)難以實現,但我們可以實現「全民免費計算 universal basic compute」。在未來,所有人都可以免費獲得 GPT 的算力,可以使用、轉售或捐贈。

「這個想法是,隨著 AI 變得更加先進,並嵌入到我們生活的方方面面,擁有像 GPT-7 這樣的大語言模型單元可能比金錢更有價值,你擁有了部分生產力,」奧特曼解釋道。

GPT-4o 的發布,或許就是 OpenAI 朝著這方面努力的一個開始。

是的,這還只是個開始。

最後提一句,今天 OpenAI 博客中展示的「Guessing May 13th’s announcement.」的視頻,幾乎完全撞車谷歌明天 I/O 大會的一個預熱視頻,這無疑是對谷歌的貼臉開大。不知道看完今天 OpenAI 的發布,谷歌有沒感到巨大壓力?